Indice

He de confesarlo: el mundo de la inteligencia artificial está lleno de hype. Cada semana aparecen modelos, benchmarks y promesas de “revolución” que luego resultan ser mejoras incrementales o simples campañas de marketing. A veces cuesta distinguir entre lo que realmente supone un cambio profundo y lo que solo busca titulares.

Por eso, cuando escuché hablar de Kimi K2 Thinking, decidí mirar con cautela. Ya viví algo similar con el lanzamiento de DeepSeek, que analicé en su momento en mi artículo DeepSeek R1 no es el mejor, es mucho más que eso.

Y, sinceramente, pensé que tardaríamos mucho tiempo en volver a ver algo tan disruptivo. Pero me equivoqué: Moonshot AI acaba de hacerlo otra vez.

Una nueva vuelta de tuerca en la IA abierta

¿Recuerdas el terremoto que provocó DeepSeek hace unos meses? Un modelo open source capaz de mirar de tú a tú a los gigantes americanos sin depender de supercomputadoras mastodónticas. Pues bien, ha vuelto a pasar. Y esta vez, la sorpresa es aún mayor.

Moonshot AI —la startup china fundada en 2023 por el brillante Yang Zhilin (ex–Google Brain y Carnegie Mellon)— acaba de sacudir el panorama con su nuevo modelo Kimi K2 Thinking.

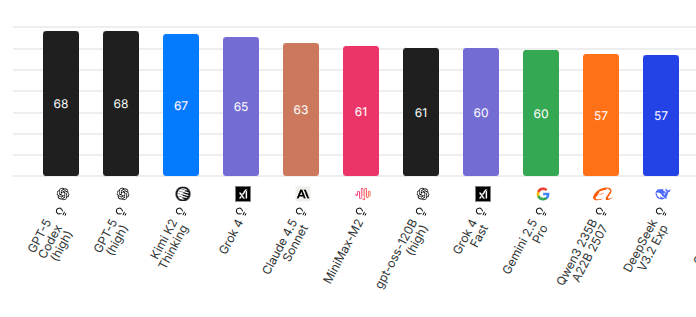

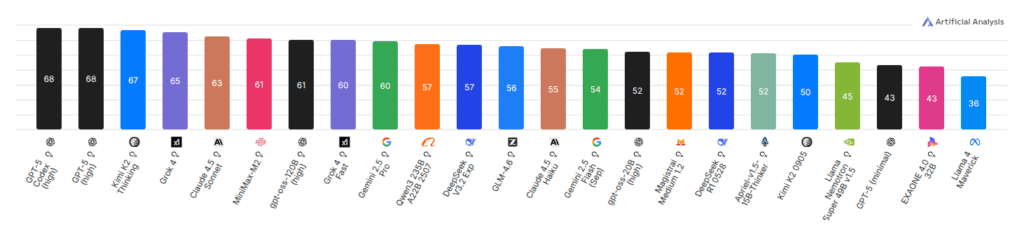

El dato clave: según el ranking de Artificial Analysis, K2 Thinking se ha colocado en el puesto #3 mundial, solo por detrás del todopoderoso GPT-5 High de OpenAI.

- ✅ Supera a Claude, Gemini, Grok y la mayoría de modelos cerrados.

- ✅ Es 100 % open source.

- ✅ Y ya puedes probarlo gratis.

¿Qué hay detrás de este salto?

Moonshot AI no es una startup cualquiera. En apenas dos años ha conseguido:

- Más de 1.270 millones de dólares en financiación (Alibaba, Tencent, Sequoia China).

- Una valoración de 3.300 millones.

- Un liderazgo técnico de primer nivel con Yang Zhilin, coautor de Transformer-XL y XLNet.

Su filosofía es clara: alcanzar la AGI a través de la investigación abierta.

⚙️ Kimi K2 Thinking: un tour de force técnico

- 1 billón de parámetros con arquitectura MoE (solo 32 B activos por pasada).

- Contexto de hasta 256.000 tokens, ideal para razonamientos de largo alcance.

- Cuantización nativa INT4: reduce a la mitad el uso de memoria GPU y duplica la velocidad de inferencia sin pérdida de precisión (de 1,03 TB a 594 GB).

- Capaz de mantener coherencia en 200-300 llamadas secuenciales a herramientas.

- Heavy Mode: ejecuta 8 trayectorias de razonamiento en paralelo para converger en la mejor respuesta.

- Rendimiento SOTA: 44,9 % en HLE, 71,3 % en SWE-bench Verified, 99,1 % en AIME25.

Y una demostración que ha dejado a muchos con la boca abierta:

El desarrollador Awni Hannun ejecutó Kimi K2 Thinking en dos Mac M3 Ultra (512 GB RAM cada una) usando pipeline parallelism, generando unos 3.500 tokens a ~15 tokens/segundo en formato INT4 nativo, sin pérdida de calidad.

Es decir: un modelo de 1 billón de parámetros corriendo en hardware Apple Silicon de escritorio con rendimiento productivo.

Ver el tweet original de Awni Hannun

Benchmarks que lo consolidan como referente

- SWE-bench Verified: 71,3 % (supera a MiniMax-M2).

- BrowseComp: 60,2 % (mejor rendimiento en tareas agenticas).

- LiveCodeBench v6: 83,1 % (codificación de élite).

Qué significa esto (y por qué deberías prestar atención)

1️⃣ Despliegue local y autonomía total

El modelo completo está disponible en Hugging Face:

moonshotai/Kimi-K2-Thinking

Si tienes suficiente VRAM (múltiples GPUs A100/H100 o un setup con Mac M3 Ultra), puedes ejecutarlo on-premise y olvidarte por completo de las APIs externas.

2️⃣ Privacidad y soberanía de datos

En un momento donde la información sensible vale oro, ejecutar el modelo localmente significa que tus prompts, tu código y tu documentación no salen de tu infraestructura.

Sin intermediarios, sin filtraciones, sin dependencia de terceros.

3️⃣ Hardware “modesto” para lo que ofrece

Aunque “1 billón de parámetros” suene enorme, la arquitectura MoE y la cuantización INT4 reducen muchísimo los requisitos.

Ya no necesitas un clúster de 8×H100: con 2× Mac M3 Ultra o una multi-GPU equivalente, puedes ejecutar un modelo de primer nivel.

Un hito impensable hace solo unos meses.

4️⃣ #1 en Hugging Face

A pocos días de su lanzamiento, Kimi K2 Thinking ya es número uno en descargas y tendencias en Hugging Face.

La comunidad lo está adoptando con entusiasmo: esto no es solo hype, es utilidad real.

5️⃣ Más allá del debate geopolítico

Algunos se preocupan por el hecho de que el modelo sea “chino”. Pero seamos realistas: ¿un modelo estadounidense es intrínsecamente más seguro?

Con las tensiones actuales —bloqueos a TikTok, políticas de datos y discursos sobre “países hostiles”— queda claro que la transparencia open source es el verdadero antídoto frente a la desconfianza.

6️⃣ Prueba el modelo hoy (y mira este vídeo explicativo en español)

Si quieres probarlo directamente, entra en https://www.kimi.com/

Recuerda activar el “Thinking Mode” para desbloquear sus capacidades de razonamiento profundo.

Y si prefieres una explicación clara en español, aquí tienes un excelente vídeo que resume todo lo que supone este nuevo modelo:

También puedes consultar el reporte técnico completo:

moonshotai.github.io/Kimi-K2/thinking.html

En resumen

Sí, hay mucho ruido en el mundo de la IA, y distinguir entre hype y progreso real no siempre es fácil.

Pero Kimi K2 Thinking tiene todos los ingredientes para ser algo más que una moda pasajera: rendimiento tangible, código abierto, comunidad activa y accesibilidad real.

Puede que estemos ante ese raro momento en que el hype y la innovación por fin coinciden.

Y si DeepSeek fue el primer aviso, Kimi K2 Thinking es la confirmación de que la IA abierta ha entrado en una nueva era.

Contenidos relacionados

No se ha encontrado ninguno

Subir

Deja una respuesta